论文翻译:2021_ICASSP 2021 ACOUSTIC ECHO CANCELLATION CHALLENGE: INTEGRATED ADAPTIVE

论文地址:https://域名/abstract/document/9414462

ICASSP 2021声学回声消除挑战:结合时间对准的自适应回声消除和基于深度学习的残余回声加噪声抑制

摘要:

本文描述了一种用于ICASSP 2021年声学回声消除挑战赛的三级声学回声消除和抑制框架。第一阶段采用分块频域自适应滤波,在不引入近端语音失真的情况下消除线性回声分量,并预先补偿远端参考信号与麦克风信号之间的时延。在第二阶段,提出了一种结合门控循环单元的深复杂U-Net来进一步抑制残余回声分量。在最后一阶段,训练一个极小的深度复杂U-Net来抑制在第二阶段没有被完全抑制的非语音残差分量,这也可以在不显著增加计算复杂度的情况下进一步增加回声损失增强(ERLE)。实验结果表明,所提出的三阶段框架在单讲和双讲场景下均能获得高于50dB的ERLE,在双讲场景下语音质量的感知评价可提高域名左右。在MOS方面,该框架比AEC-Challenge基线ResRNN高出域名点。

关键字:AEC挑战,声学回声消除,自适应滤波,深度学习,语音增强

1 引言

考虑到2019冠状病毒(COVID-19)疫情导致大量实体会议变成虚拟会议,声学回声消除(AEC)对免提电话会议应用的重要性比以往任何时候都要高。在大多数情况下,假设声学回声路径是线性的,麦克风信号和远端参考信号之间的时延是有限的或事先知道的。在此假设下,利用传统的方法[1]可以有效地消去回声信号。然而,现有的线性声学回声消除算法的性能在许多实际应用中可能会被大大降低,因为时间延迟可能有一个很大的范围,即从0到600 ms,并且扬声器可能存在严重的非线性行为尤其是其输入信号大。此外,声学回声路径也可能是时变的,麦克风信号也可能包含一些环境噪声和混响的影响。对于实际的免提电话会议系统,上述所有问题都需要解决。

在过去的几十年里,为了提高自适应滤波算法的收敛速度,提高其对双语音[2]、[3]、[4]的鲁棒性,人们做了很多努力。在这些自适应滤波算法中,分块频域最小均方(PBFDLMS)算法在计算复杂度和算法时延之间具有良好的平衡,被ICASSP 2021 AEC挑战赛选用。在双讲情况下,为了减缓PBFDLMS算法的发散,在更新自适应滤波器系数[5]时,控制步长是很重要的。在这个挑战中,远端参考信号和麦克风信号之间的时间延迟可能非常大,即≥600ms。在这种情况下,还需要估计这个时间延迟,然后应该事先进行时间对齐,这样就可以避免使用数千个自适应滤波器系数来覆盖这个回放和记录延迟。

如果不进行后处理,可能会保留一些对电话会议系统有重大影响的残余回声分量。为此,许多研究人员在进一步抑制这些残余回声分量方面做了大量的工作。在实际应用中,当同时考虑环境噪声和残余回声时,需要对噪声和残余回声进行抑制。在过去的三十年中,已经提出了许多结合噪声和残余回声抑制的算法[6],[7]。近年来,由于深度神经网络(DNN)在揭示输入和输出之间复杂非线性关系方面的强大能力,基于DNN的端到端AEC算法表现出了比无监督算法更好的性能[8,9,10]。然而,众所周知,在真实的声学环境中,由于测试和训练条件的不匹配,网络性能往往会出现明显的下降。在[11]中,实验结果表明,结合自适应滤波算法和深度学习算法可以解决AEC系统的鲁棒性,同时保持良好的回声消除性能,适用于实际应用。

针对这一AEC挑战,我们提出了一个三级声学回声消除和抑制框架,如图1所示。在第一阶段,选择PBFDLMS算法尽可能地消除线性回声分量,预先估计和补偿时延。在第二阶段,采用深度复杂的U-Net[12]与门控循环单元(DCGRUNet)集成,进一步抑制残余回声分量。最后,通过训练一个极小深度复杂U-Net (tiny DCUNet)来抑制非语音残差分量。

图1 提出的三阶段算法框架

本文其余部分组织如下:第2节介绍了信号模型并提出了问题。在第3节中,详细描述了所提出的三阶段处理模块的总体框架。在第4节中,给出了一些主观和客观的实验结果,以验证该框架的有效性。在第5节,我们给出了一些结论。

2 信号模型

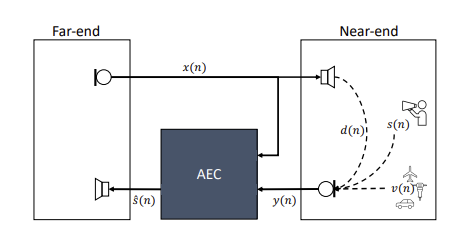

图2为声学回声消除系统示意图,接收室在左侧,发射室在右侧。远端参考信号\(r(n)\)由麦克风记录在传输室,然后传输到接收室。然后\(r(n)\)通过扬声器播放,然后通过声学回声路径\(h(n)\)传送到接收室的麦克风。因此,接收室内的麦克风信号可模拟为:

\[d(n)=r(n) * h(n)+s(n)+v(n) (1) \]其中\(∗\)为卷积,\(n\)为离散时间指标,\(s(n)\)为近端语音信号,\(v(n)\)为加性噪声。该算法的目标是利用远端参考信号\(r(n)\)的先验信息从\(d(n)\)中提取干净的语音信号\(s(n)\)。

图2 声学回声消除系统图。

在实际应用中,微型扬声器越来越受欢迎,以减少便携设备的尺寸和重量,(1)中的线性模型可能并不总是成立,可能会出现非线性回声问题,需要认真考虑[13],[14]。在这个AEC挑战中,线性和非线性回声分量都需要去除。在本文中,我们建议使用PBFDLMS在第一阶段去除线性回声分量。残差和非线性回声分量被基于深度学习的算法进一步抑制,使用多个输入信号,灵感来自[15]。与[15]的方法相比,我们直接估计干净的语音复频谱,而不需要估计掩模来抑制回声,为此我们修改了深度复杂的U-Net[12]。通过这样做,可以在客观和主观测量中获得更好的性能。其机理是利用深度复杂网络[16]不仅可以优化幅值,而且可以优化相位。

3 拟议的框架

3.1 自适应滤波器

对于自适应滤波算法,首先估计远端参考信号与传声器信号之间的时延,然后对自适应滤波系数进行时间对齐。没有时间对齐,自适应滤波器长度应该足够大,以覆盖播放和记录延迟。随着自适应滤波器长度的增加,计算量明显增加。为了降低计算复杂度,提高收敛速度,本文提出采用广义互相关相位变换(GCC-PHAT)方法[17]估计时延,然后用估计的时延\(\Delta\)对远端参考信号进行时延估计。

时间对准后,对时间对准的远端参考信号\(r(n-\Delta)\)和麦克风信号\(d(n)\)进行短时快速傅里叶变换(STFT),分别表示为\(R(l, k)\)和\(D(l, k)\),其中\(l\)表示时间帧指数,\(k\)表示频域指数。注意,\(R(l, k)\)和\(D(l, k)\)都是复值,分别表示时频域窗口\((l, k)\)中\(r(n-\Delta)\)和\(d(n)\)的复频谱。通过PBFDLMS算法估计声学回声,并从麦克风信号中减去误差信号\(E(l, k)\),如图3所示。关于PBFDLMS算法的更多细节可以在[1]中找到。

图3 第一阶段架构

对于双讲场景,需要根据麦克风信号和远端参考信号优化步长。在本文中,我们利用麦克风信号和远端参考信号的幅值平方相干(MSC)来控制自适应滤波系数的更新。当MSC接近1时,自适应滤波系数可以快速更新。相反,当MSC接近0时,自适应滤波系数应停止更新。在某些情况下,由于回声路径有一定的发散性,或者回声路径变化很快,我们无法快速跟踪这种变化,所以可能用自适应滤波算法放大回声,而不是消除/减少回声。为了解决这个问题,我们直接在每个时频窗口中约束误差信号\(E(l, k)\)的大小,它是由

\[|E(l, k)|=\min \{|E(l, k)|, \beta|D(l, k)|\} (2) \]其中\(\beta \geq 1\)为常数值。在本文中,使用\(\beta = 1\)。结果表明,利用该约束对提高自适应滤波算法的鲁棒性具有重要意义,特别是在声学回声路径变化迅速的情况下。请注意,\(\beta\)值不能小于1,否则会显著降低自适应滤波算法的性能。注意,我们只限制了幅度,而误差信号的相位保持不变。

3.2 深度复杂的U-Net与GRU集成

在本研究中,为了抑制非线性和残差线性回声分量,我们采用深度复杂U-Net (DCU-Net)作为主网络,该网络在深度噪声抑制任务[12]中表现出了令人印象深刻的性能。然而,由于AEC挑战任务需要实时实现,因此需要对其进行改进。首先,原始配置是基于非因果设置的。也就是说,在训练和测试过程中,整个话语信息都涉及到计算中,阻碍了实时推理。其次,由于只提供了卷积编码器和解码器,没有有效地探索时间相关性。为了解决上述问题,我们重新设计了称为DCGRU-Net-22的原始体系结构。有几处修改,详见图4。首先,将时间轴上所有的核数和步数设置为1,避免了对未来信息的计算。其次,与[18]类似,我们在门通循环单元(GRU)[19]中加入循环连接,以更好地探索编码器层与其对应解码器之间的时间连接。值得注意的是,与[12]类似,所有的运算,包括卷积、批归一化和非线性激活都是基于复原理的,这已经被证明在许多任务中它可以比实值运算获得更好的性能[20,21,22]。这里的值“22”表示编码器和解码器的层数为22。

图4 DCGRU-Net-22的体系结构说明。它由三个主要组件组成,即编码器块、解码器块和GRU块。图中还给出了每一层的输出通道数量,双实线表示复杂的数据流。

在DCGRU-Net-22中,多个信号的实分量和虚分量(包括麦克风信号\(D (l, k)\)、远端参考信号\(R(l, k)\)和误差信号\(E (l, k)\)沿通道轴连接作为输入特征。其输出也有两个分量,即增强的近端信号属于S(l, k)的实分量和虚分量。每一层有一个复杂的卷积神经网络(CNN),具有复杂的batch-normalization和ReLU 激活函数[23]。对于每个编码器输出,不再是单纯的跳过连接,而是将其整形为时间序列向量,然后馈给GRU层进行序列建模,再将其整形回原始大小,最后与相应的解码器层连接。

3.3 微深复杂的U-Net后处理

在第I和第II阶段,仍然存在一些非语音残余回声分量。此外,有些环境噪声在嘈杂环境中不经过训练是无法抑制的。考虑到声学回声的语音结构已经得到了充分的抑制,我们可以将这些非语音残留回声分量视为非平稳噪声分量,可以通过基于深度学习的后处理算法进一步抑制。图5描绘了第三阶段的框架。在这个阶段,编码器和解码器的层数只有16层,这可以归结为两层。一方面,经过前两个阶段,语音质量有了很大的提高,只剩下一些失真需要缓解。另一方面,网络参数越少,计算复杂度越低。我们在这里将Stage III中的网络表示为Tiny DCU-Net-16。

图5 微型DCU-Net-16的架构说明。请注意,编码器块与DCGRU-Net-22中的稍有不同。

需要注意的是,第三阶段的网络只接收到增强信号属于\(\tilde{S}(l, k)\)的实部和虚部作为输入,输出是增强信号属于\(\hat{S}(l, k)\)的实部和虚部。因此,我们可以使用无噪声语音对在第三阶段训练模型。

4 实验结果

4.1 实验装置

在本文中,将所有时域信号转换为频域信号,对一帧连续320个样本加汉宁窗,帧移160个样本。在提出的框架中,我们不使用任何未来的信息来进一步提高性能,因此由于采样率为16000 Hz,算法延迟为30 ms。PFBLMS算法中使用的子块数量为24。

在DCGRU-Net-22的训练阶段,将远端参考信号\(R (l, k)\)、麦克风信号\(D (l, k)\)和残差信号\(E (l, k)\)的实部连接起来,形成一个张量维度\(3×T×161\),其中\(T\)表示每个独立音频样本的帧数。它们的虚部也用同样的方法处理。拟议的DCGRU-Net-22的详细设置可在线获得。网络中只使用当前帧和过去4帧,这意味着在Stage II中没有额外的延迟。将AEC挑战释放的所有合成数据集作为训练数据集,利用Adam优化器对网络进行训练,使网络输出与近端干净语音之间的最小平方误差(minimum square error, MSE)进行优化。提出的DCGRU-Net-22的可训练参数数为2506388≈域名。在训练Tiny DCU-Net-16时,我们使用INTERSPEECH 2020 DNS挑战[24]发布的干净语音和噪声语音数据集。其可训练参数数为108162≈108K。损失函数和优化器与DCGRUNet-22相同。在Tiny DCU-Net-16中只使用当前帧和过去15帧,这意味着在Stage III中没有额外的延迟。

4.2 客观的测量结果

为了直观地展示这三个阶段的效果,我们分别绘制了麦克风信号、增强信号的I阶段、II阶段和III阶段的光谱图。从图6可以看出,每个阶段都可以逐渐抑制声学回声,而近端语音保持不变。虽然图6中的PESQ评分也在逐步增加,但需要注意的是,在某些情况下,阶段III的PESQ评分可能会略低于阶段II的PESQ评分。这主要是因为Stage III使用的模型太小,在抑制非语音残留回声和某些情况下的噪声时,可能会造成一定的语音失真。然而,我们发现第三阶段在提高ERLE中起重要作用。为了实现可靠的PESQ评价,我们从合成数据集中随机选择100个话语计算PESQ得分,然后将这些话语在每个阶段的平均PESQ得分汇总在表1中。可以看到,与原始麦克风信号相比,提出的三阶段框架的PESQ分数可以提高域名左右。为了测量ERLE,我们从盲测试数据集中随机选择10个语音,得到三种不同场景下的平均ERLE结果,包括双讲场景(DT)、远端单语场景(ST FE)和有动作的双讲场景(ST FE)。表2给出了每个阶段的平均ELRE结果。注意,在计算ERLE之前,只需要检测远端段。可以看到,ERLE在单讲和双讲场景中都超过50分贝。

图6 合成数据集中的双讲话语。(a)原始麦克风(PESQ:域名),(b) PBFDLMS处理的增强语音(PESQ:域名),(c) DCGRU-Net-22处理的增强语音(PESQ: 域名), (d)Tiny DCU-Net-16处理的增强语音(PESQ:域名)。

表1 每个阶段的PESQ结果

表2。ERLE(dB)在每个场景中的结果

4.3 AEC挑战赛的主观结果

根据AEC 挑战组织者提供的主观测试结果,该框架提高了MOS约域名点,表明该框架在单语音和双语音场景下抑制回声的有效性。我们在Intel Core i5-4300 CPU上运行框架代码,每帧的总计算时间约为域名 ms,远远小于10 ms。第I阶段、第II阶段和第III阶段每帧计算时间分别为域名、域名和域名。

5 结论

本文提出了AEC挑战的三个阶段框架。在这个框架中,我们实现了带有时间对齐的PBFDLMS来消除线性回声分量。在此基础上,提出两种深度学习网络同时抑制残差回声和非语音残差噪声。主客观测量结果均表明了该框架的有效性。今后的工作应集中在提高PBFDLMS不收敛时的回声抑制能力。

6 参考文献

[1] B Farhang, Adaptive filters: theory and applications, John Wiley & Sons, 2013.

[2] Munjal A, Aggarwal V, and Singh G, “Rls algorithm for acoustic echo cancellation,” COIT, March, vol. 29, 2008.

[3] Eneman K and Moonen M, “Iterated partitioned block frequency-domain adaptive filtering for acoustic echo cancellation,” IEEE Transactions on Speech and Audio Processing, vol. 11, no. 2, pp. 143–158, 2003.

[4] Halimeh M. M and Kellermann W, “Efficient multichannel nonlinear acoustic echo cancellation based on a cooperative strategy,” in ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP).IEEE, 2020, pp. 461–465.

[5] Paleologu C, Benesty J, and Ciochina S, “A variable step-sizeaffine projection algorithm designed for acoustic echo cancellation,” IEEE Transactions on Audio, Speech, and Language Processing, vol. 16, no. 8, pp. 1466–1478, 2008.

[6] Gustafsson S, Martin R, Jax P, and et al, “A psychoacoustic approach to combined acoustic echo cancellation and noise reduction,” IEEE Transactions on Speech and Audio Processing, vol. 10, no. 5, pp. 245–256, 2002.

[7] Lu W, Zhang L, Chen J, and et al, “Generalized combined nonlinear adaptive filters for nonlinear acoustic echo cancellation,” in 2019 Asia-Pacific Signal and Information Processing Association Annual Summit and Conference (APSIPA ASC). IEEE, 2019, pp. 1220–1225.

[8] Zhang H and Wang D. L, “Deep learning for acoustic echo cancellation in noisy and double-talk scenarios,” Training, vol. 161, no. 2, pp. 322, 2018.

[9] Zhang H, Tan K, and Wang D. L, “Deep learning for joint acoustic echo and noise cancellation with nonlinear distortions.,” in INTERSPEECH, 2019, pp. 4255–4259.

[10] Lei Q, Chen H, Hou J, and et al, “Deep neural network based regression approach for acoustic echo cancellation,” in Proceedings of the 2019 4th International Conference on Multimedia Systems and Signal Processing, 2019, pp. 94–98.

[11] Ma L, Huang H, Zhao P, and et al, “Acoustic echo cancellation by combining adaptive digital filter and recurrent neural network,” arXiv preprint arXiv:域名7, 2020.

[12] Choi H. S, Kim J. H, Huh J, and et al, “Phase-aware speech enhancement with deep complex u-net,” in International Conference on Learning Representations, 2018.

[13] Azpicueta R. L. A, Zeller M, Figueiras V. A. R, and et al, “Adaptive combination of volterra kernels and its application to nonlinear acoustic echo cancellation,” IEEE Transactions on Audio, Speech, and Language Processing, vol. 19, no. 1, pp. 97–110, 2010.

[14] Malik S and Enzner G, “State-space frequency-domain adaptive filtering for nonlinear acoustic echo cancellation,” IEEE Transactions on audio, speech, and language processing, vol. 20, no. 7, pp. 2065–2079, 2012.

[15] Carbajal G, Serizel R, Vincent E, and et al, “Multiple-input neural network-based residual echo suppression,” in 2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2018, pp. 231–235.

[16] Li A. D, Zheng C. S, Peng R. H, and Li X. D, “On the importance of power compression and phase estimation in monaural speech dereverberation,” JASA Express Letters, vol. 1, no. 1, pp. 1–7, 2021.

[17] Knapp C and Carter G, “The generalized correlation method for estimation of time delay,” IEEE transactions on acoustics, speech, and signal processing, vol. 24, no. 4, pp. 320–327, 1976.

[18] Wang W, Yu K, Hugonot J, and et al, “Recurrent u-net for resource-constrained segmentation,” in Proceedings of the IEEE International Conference on Computer Vision, 2019, pp. 2142–2151.

[19] Chung J. Y, Gulcehre C, Cho K. H, and Bengio Y, “Empirical evaluation of gated recurrent neural networks on sequence modeling,” arXiv preprint arXiv:域名, 2014.

[20] Rezaee M, Mahdianpari M, Zhang Y, and Salehi B, “Deep convolutional neural network for complex wetland classification using optical remote sensing imagery,” IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, vol. 11, no. 9, pp. 3030–3039, 2018.

[21] Zhang Z, Wang H, Xu F, and Jin Y, “Complex-valued convolutional neural network and its application in polarimetric sar image classification,” IEEE Transactions on Geoscience and Remote Sensing, vol. 55, no. 12, pp. 7177–7188, 2017.

[22] Hu Y, Liu Y, Lv S, and et al, “Dccrn: Deep complex convolution recurrent network for phase-aware speech enhancement,” arXiv preprint arXiv:域名4, 2020.

[23] Trabelsi C, Bilaniuk O, Zhang Y, and et al, “Deep complex networks,” arXiv preprint arXiv: 170509792.

[24] Reddy C. K. A, Beyrami E, H Dubey, and et al, “The interspeech 2020 deep noise suppression challenge: Datasets, subjective speech quality and testing framework,” arXiv preprint arXiv:域名2, 2020.