特征值和特征向量

1、定义

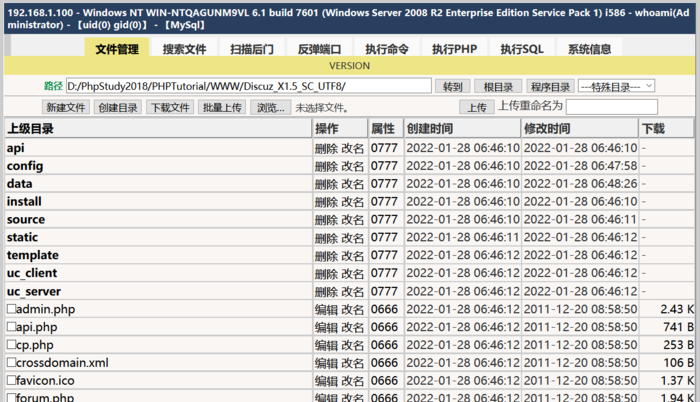

假设我们有一个n阶的矩阵A以及一个实数![[公式]](/upload/image/20220314/域名)

那么我们就称实数是矩阵A的特征值,非零向量x是矩阵A的特征向量。

2、特征矩阵与维度

特征值和特征向量是针对矩阵而言的,显然这个矩阵就是我们的特征矩阵,特征矩阵中每一列为我们的一个特征,相当于矩阵中的一个列向量,我们可以认为每一列就是一个维度,假设有n列,且这n列线性无关,那么特征矩阵就有n个维度。

3、矩阵的秩:

在线性代数中,一个矩阵A的列秩是A的线性独立的纵列的极大数目。类似地,行秩是A的线性无关的横行的极大数目。即如果把矩阵看成一个个行向量或者列向量,秩就是这些行向量或者列向量的秩,也就是极大无关组中所含向量的个数。

4、矩阵乘法的几何意义:

矩阵是由若干向量组成的(参考线性方程组),依次可以自然的把矩阵算法看作是两个矩阵同维向量之间的内积,而内积的意义是两向量通向投影的乘积,这是我们可以想象到的。其实,对于矩阵算法C=AB,我们可以认为矩阵C是矩阵A经过某种变换得到的,也可以看作是矩阵B经过某种变换得到的,变换矩阵的例子如下:

(1)

这个变换矩阵会把原来的3维图形向x-y面投影。原因:变换矩阵为3列,代表3个维度,第一列,也是3维空间中的第一个向量,也是第一个维度,也可以成为三维空间中的坐标轴x对应的向量为(1,0,0),也就说x轴对应不变,同理y轴也对应不变,而z轴对应的变换矩阵全为0,因此相当于将三维空间中的所有点对应的值的x坐标和y坐标保留不变,z坐标全部变为0,也就是在x-y面上的投影啦。

(2)

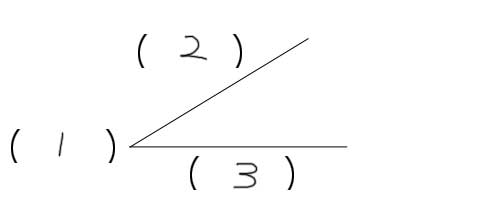

这个变换矩阵会把原图形对x轴进行镜像。原因:与上同理。

(3)

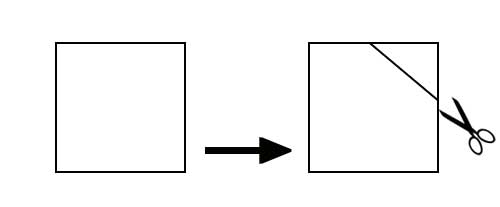

这个变换矩阵会把原2D图像相对原点逆时针旋转30度。

5、矩阵的分解

如果说一个向量v是方阵A的特征向量,将一定可以表示成下面的形式:

这时候λ就被称为特征向量v对应的特征值,一个矩阵的一组特征向量是一组正交向量。特征值分解是将一个矩阵分解成下面的形式:

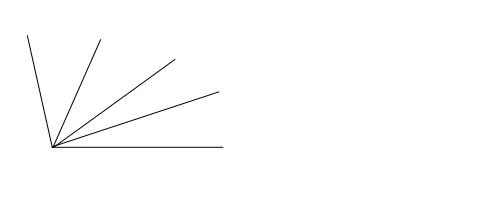

其中Q是这个矩阵A的特征向量组成的矩阵,Σ是一个对角阵,每一个对角线上的元素就是一个特征值。首先,要明确的是,一个矩阵其实就是一个线性变换,因为一个矩阵乘以一个向量后得到的向量,其实就相当于将这个向量进行了线性变换。若变换矩阵为:

那么它描述变化之后的样子是下面的样子:(参考https://域名/article/域名)

这其实是在平面上对一个轴进行的拉伸变换(如蓝色的箭头所示),在图中,蓝色的箭头是一个最主要的变化方向(变化方向可能有不止一个),如果我们想要描述好一个变换,那我们就描述好这个变换主要的变化方向就好了。反过头来看看之前特征值分解的式子,分解得到的Σ矩阵是一个对角阵,里面的特征值是由大到小排列的,这些特征值所对应的特征向量就是描述这个矩阵变化方向(从主要的变化到次要的变化排列)。

当矩阵是高维的情况下,那么这个矩阵就是高维空间下的一个线性变换,这个线性变化可能没法通过图片来表示,但是可以想象,这个变换也同样有很多的变换方向,我们通过特征值分解得到的前N个特征向量,那么就对应了这个矩阵最主要的N个变化方向。我们利用这前N个变化方向,就可以近似这个矩阵(变换)。也就是之前说的:提取这个矩阵最重要的特征。总结一下,特征值分解可以得到特征值与特征向量,特征值表示的是这个特征到底有多重要,而特征向量表示这个特征是什么,可以将每一个特征向量理解为一个线性的子空间,我们可以利用这些线性的子空间干很多的事情。不过,特征值分解也有很多的局限,比如说变换的矩阵必须是方阵。

6、PCA中的特征值和特征向量

PCA是用来降维的算法,PCA使用方差作为信息量的衡量指标,并且特征值分解来找出空间V。降维时,它会通过一系列数学的神秘操作(比如说,产生协方差矩阵)将特征矩阵X分解为以下三个矩阵,其中是Q和Q-1辅助的矩阵,Σ是一个对角矩阵(即除了对角线上有值,其他位置都是0的矩阵),其对角线上的元素就是方差。降维完成之后,PCA找到的每个新特征向量就叫做“主成分”,而被丢弃的特征向量被认为信息量很少,这些信息很可能就是噪音。